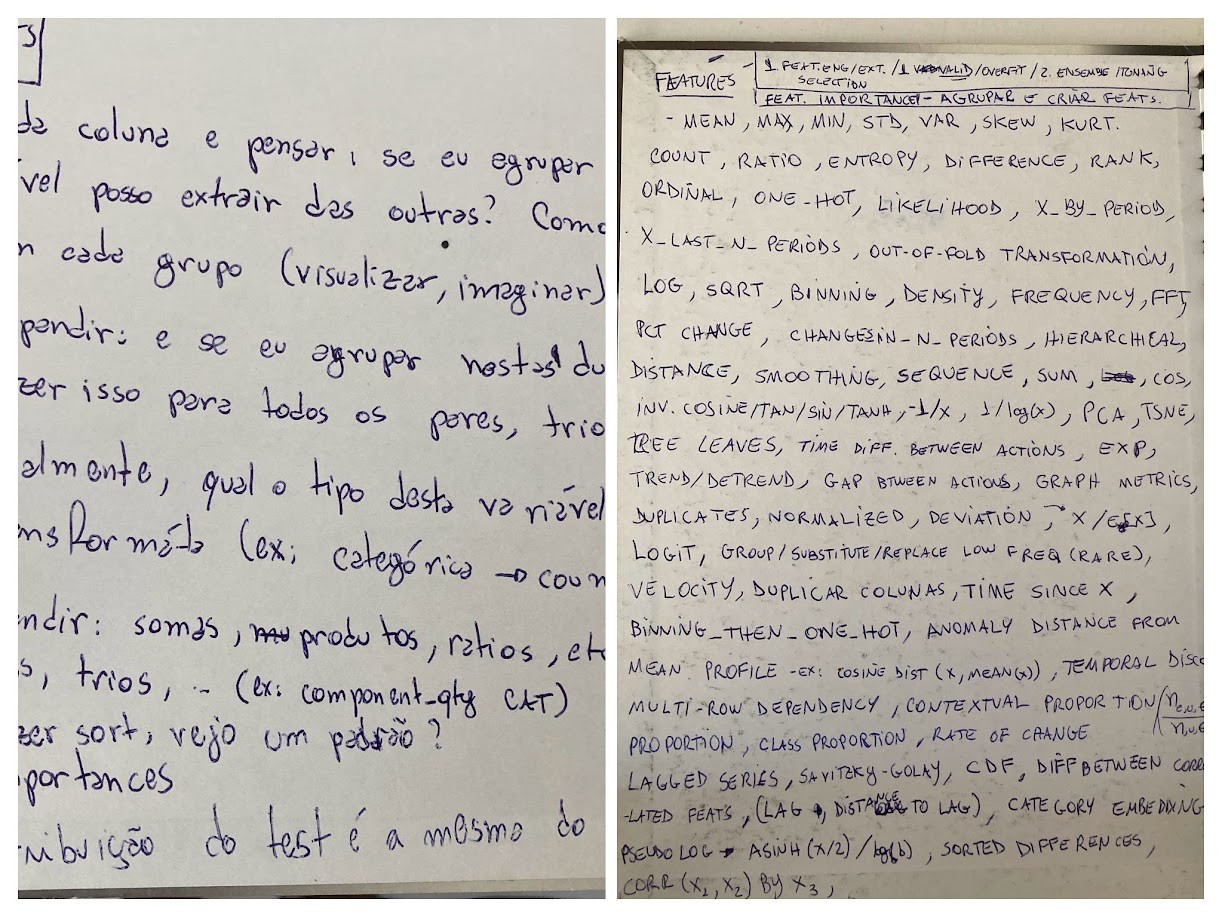

Encontrei um caderno antigo com anotações de competições do Kaggle onde escrevi uma lista enorme de ideias de features de ML para dados tabulares nas capas para quando eu ficasse sem ideias. Pedi ao Gemini para transcrever e aqui está o resultado. Aproveite! Instruções Gerais Para Feature Engineering em Dados Tabulares Ver cada coluna e pensar: se eu agrupar nesta, que variável posso extrair das outras? Como serão as séries em cada grupo (visualizar, imaginar)?...